DeepSeek V3.1 marque un bond en avant significatif dans le domaine des modèles linguistiques, établissant de nouveaux standards en matière de raisonnement, de gestion du contexte et de génération de texte.

Il s’agit d’un grand modèle de langage (LLM) hybride open-source conçu pour répondre aux besoins des développeurs en intelligence artificielle les plus exigeants.

Cette nouvelle version met l’accent sur des capacités techniques innovantes : compréhension fine du langage naturel, génération de texte cohérente, mémoire contextuelle étendue, modes de raisonnement adaptatifs, utilisation d’outils externes et performances de pointe sur de nombreux benchmarks.

Dans cet article, nous allons explorer en détail les caractéristiques techniques de DeepSeek V3.1 et ses capacités majeures, avec des exemples concrets pour illustrer comment les développeurs peuvent exploiter ce modèle dans leurs applications (API, chatbots, analyse de documents, fine-tuning, prompts complexes, etc.).

Caractéristiques techniques clés de DeepSeek V3.1

- Fenêtre de contexte ultra-étendue (128 k tokens) : DeepSeek V3.1 peut exploiter des contextes allant jusqu’à 128 000 tokens (l’équivalent de plus de 100 pages de texte). Cette capacité hors norme de mémoire contextuelle lui permet de traiter des documents très longs, de gérer de vastes historiques de conversation, ou de croiser de multiples sources d’information au sein d’une même requête, tout en conservant la cohérence contextuelle.

- Deux modes de raisonnement (« Thinking » vs « Non-Thinking ») : Le modèle introduit un fonctionnement hybride unique : il supporte à la fois un mode « non-thinking » pour des réponses factuelles et concises, et un mode « thinking » pour des raisonnements détaillés pas-à-pas. En pratique, cela signifie que DeepSeek V3.1 peut fournir soit des réponses directes et rapides aux questions, soit des réponses explicitement réfléchies, où il décompose le problème en étapes (de type chain-of-thought) en citant ses sources ou en justifiant chaque étape. Le développeur peut facilement basculer entre ces deux modes selon les besoins de l’application.

- Architecture massive Mixture-of-Experts (MoE) : Sous le capot, DeepSeek V3.1 repose sur une architecture Mixture-of-Experts à très grande échelle, comptant 671 milliards de paramètres au total. Toutefois, grâce à cette approche MoE, seul un sous-ensemble d’environ 37 milliards de paramètres est activé pour chaque token généré. Cela lui permet de combiner la richesse d’un modèle géant (intégrant de multiples spécialités ou « experts ») avec l’efficacité d’un modèle plus léger à l’inférence. Le modèle utilise en outre des techniques avancées d’optimisation comme l’attention latente multi-têtes et la prédiction multi-tokens pour gérer efficacement ce volume et accélérer la génération.

- Intégration d’outils et apprentissage multi‑agent : DeepSeek V3.1 a été pensé pour fonctionner dans des workflows agentiques, où le modèle collabore avec des outils externes (moteur de recherche, exécution de code, APIs, etc.) dans le cadre de raisonnements multi-étapes. Il est capable de déclencher des actions – par exemple rechercher des informations en ligne ou appeler une fonction – et d’utiliser les résultats pour affiner sa réponse. Son entraînement supplémentaire (post-training) a significativement amélioré ses performances en usage d’outils et tâches d’agent complexes, le positionnant comme un modèle idéal pour l’ère des IA multi-agents. En somme, DeepSeek V3.1 peut servir de cerveau central dans des agents conversationnels avancés, apte à planifier des étapes et interagir avec un environnement.

- Performances de pointe sur les benchmarks : Sur de nombreux défis standard, DeepSeek V3.1 rivalise avec les meilleurs modèles du moment. Par exemple, il atteint 93,7 % de réussite sur MMLU-Redux (évaluation de connaissances de niveau universitaire) en mode raisonnement – un score au sommet des modèles open-source. Il figure également parmi les meilleurs en codage, avec environ 75 % de succès pass@1 sur des concours de programmation comme LiveCode ou Aider, témoignant d’une compréhension solide des problèmes algorithmiques. En mathématiques, il résout des compétitions de haut niveau (AIME) avec plus de 90 % de bonnes réponses. Ces résultats illustrent une polyvalence exceptionnelle, couvrant le NLP général, le raisonnement complexe et la génération de code avec une qualité proche des modèles fermés de référence.

- Optimisation pour l’efficacité (vitesse et coût) : Malgré son ampleur, DeepSeek V3.1 a été optimisé pour réduire la latence et le coût de calcul. Il supporte les calculs en précision BF16 et même FP8 sur les GPU modernes, ce qui permet d’accélérer l’inférence et de diminuer l’usage mémoire sans perte notable de précision. Son mode « thinking » a également gagné en rapidité : produire des raisonnements détaillés est plus rapide qu’auparavant grâce aux optimisations d’architecture et à l’entrainement ciblé sur l’efficacité. En pratique, les développeurs bénéficient de réponses plus rapides, y compris lors de générations longues ou complexes, et d’une meilleure évolutivité pour le déploiement à grande échelle.

- Open source et compatibilité : DeepSeek V3.1 est publié en open-source sous licence MIT, avec ses poids de modèle disponibles librement (y compris la version base non instruite et la version fine-tunée conversationnelle). Il est ainsi ouvert à la communauté pour des adaptations ou des intégrations personnalisées. De plus, l’accès au modèle est simplifié par une API compatible OpenAI : on peut interagir avec DeepSeek V3.1 via des endpoints API de type ChatGPT (par exemple via la plateforme OpenRouter) sans avoir à héberger le modèle localement. Le modèle s’intègre aussi nativement dans l’écosystème Hugging Face Transformers, et de nombreuses variantes quantisées ou spécialisées sont déjà proposées par la communauté pour faciliter son déploiement (plus de 19 modèles fine-tunés ou quantifiés dérivés sont listés). Cette compatibilité et ouverture offrent aux développeurs une flexibilité maximale pour tester, utiliser et personnaliser DeepSeek selon leurs besoins.

Compréhension du langage naturel et génération de texte

En tant que modèle de langage de dernière génération, DeepSeek V3.1 excelle en traitement automatique du langage naturel.

Il est capable de comprendre des requêtes complexes et de générer des réponses textuelles très cohérentes, dans divers registres et domaines. Que ce soit pour de la conversation générale, de la rédaction de documents, du résumé de texte, de la traduction ou de l’explication technique, le modèle délivre un texte fluide et pertinent.

Grâce à son immense corpus d’entraînement (plus de 14 000 milliards de tokens de données variées selon le rapport technique), DeepSeek a acquis une base de connaissances étendue et une maîtrise des styles d’écriture.

Signe de ses capacités linguistiques avancées, DeepSeek V3.1 égale voire dépasse les performances des meilleurs chatbots propriétaires sur certaines tâches complexes.

Par exemple, sur des questions de culture générale ou des problèmes nécessitant de la créativité, ses réponses sont détaillées, nuancées et souvent comparables en qualité à celles de GPT-4 ou d’autres modèles fermés haut de gamme.

Le modèle s’adapte aussi bien aux questions ouvertes (« Explique-moi la théorie des trous noirs en termes simples. ») qu’aux demandes précises (« Donne-moi les grandes étapes pour implémenter un arbre binaire de recherche en Python. »), en fournissant du contenu à la fois informatif et contextuellement approprié.

Il convient de souligner que DeepSeek V3.1 est multilingue et particulièrement performant en français.

Issu d’un projet initialement lancé en Chine, le modèle a été entraîné et optimisé pour comprendre les nuances de la langue française, offrant ainsi aux utilisateurs francophones des réponses naturelles et contextuelles de haute qualité Contrairement à certains LLM principalement entraînés en anglais, DeepSeek traite le français sans difficulté et peut basculer entre les langues au besoin.

Pour un développeur souhaitant un assistant conversationnel en français, c’est un atout de taille : on peut l’interroger dans la langue de Molière et obtenir une réponse précise et idiomatique, ou même lui faire traduire/générer du texte dans plusieurs langues.

En synthèse, sur toutes les tâches classiques de NLP (questions-réponses, résumés, génération d’histoires, traduction, extraction d’informations, etc.), DeepSeek V3.1 offre des performances de pointe et une très haute qualité de génération de texte, ce qui le rend immédiatement exploitable pour construire des chatbots avancés, des outils d’assistance à la rédaction, ou tout autre système conversationnel intelligent.

Sa polyvalence linguistique et sa capacité à maintenir un contexte riche sur de longues interactions (voir section suivante) le distinguent particulièrement auprès du public développeur cherchant à créer des applications robustes de traitement du langage.

Mémoire contextuelle étendue sur 128 000 tokens

L’une des avancées majeures de DeepSeek V3.1 réside dans sa fenêtre contextuelle massivement étendue.

En effet, le modèle peut prendre en compte jusqu’à 128 k tokens de contexte dans une requête ou conversation – un chiffre sans commune mesure avec les contextes de 4k ou 8k tokens des générations précédentes de LLM.

Concrètement, 128 000 tokens représentent plus de 100 pages de texte, ce qui ouvre des possibilités inédites pour le traitement de documents longs ou de dialogues étendus.

Cette capacité de mémoire à long terme signifie qu’un développeur peut fournir à DeepSeek V3.1 de très longues entrées : par exemple, le texte complet d’un rapport technique de recherche, le contenu entier d’un site web, ou l’historique complet d’une conversation client sur plusieurs jours.

Le modèle pourra alors analyser l’intégralité de ces informations dans son contexte et s’y référer précisément pour formuler ses réponses.

Plus besoin de découper un document en morceaux trop courts : DeepSeek peut absorber d’un coup un PDF volumineux et répondre à des questions pointues s’y rapportant, tout en gardant à l’esprit les détails disséminés dans le texte.

Exemple — Interface d’une application exploitant DeepSeek V3.1 pour l’analyse d’un PDF de recherche.

L’utilisateur peut poser des questions sur le document et choisir une réponse « brève » (non-think) ou « détaillée » (think).

Le modèle fournit alors sa réponse avec éventuellement des citations du texte source. Ce type d’outil est rendu possible par la fenêtre de contexte de 128k tokens, qui permet de charger le texte complet d’un article scientifique en une seule fois..

Techniquement, pour atteindre ce contexte étendu, les chercheurs de DeepSeek ont utilisé une approche d’extension de contexte en deux phases lors de l’entraînement.

D’abord, le modèle de base (V3.1-Base) a été pré-entraîné avec un contexte allongé à 32k tokens sur un grand volume de données (plus de 630 milliards de tokens supplémentaires), puis une seconde phase d’entraînement a étendu la longueur contextuelle à 128k tokens avec ~209 milliards de tokens de documents longs.

Ce processus intensif a permis au modèle d’apprendre à gérer de très longues séquences sans perdre la cohérence ni oublier les premiers passages.

En outre, des optimisations de l’architecture (comme l’attention hiérarchique Multi-Head Latent Attention) assurent que le coût en calcul et en mémoire reste gérable malgré la longueur du contexte.

Pour les développeurs, cette longue mémoire ouvre de nouveaux cas d’usage.

On peut imaginer : générer le résumé et l’analyse d’un livre entier en une requête, construire un assistant qui converse pendant des heures en se souvenant de tous les détails mentionnés, ou analyser des bases de connaissances volumineuses (dossiers juridiques, logs techniques, documentation produit) afin de répondre à des questions précises.

DeepSeek V3.1 supprime en grande partie la barrière de la fenêtre contextuelle, ce qui permet de travailler à l’échelle du document plutôt qu’au paragraphe. C’est un atout considérable pour tous les projets d’IA nécessitant une compréhension globale de longues entrées.

Raisonnement avancé : modes “Thinking” vs “Non-Thinking”

L’une des innovations phares de DeepSeek V3.1 est son approche hybride du raisonnement à travers deux modes de fonctionnement distincts, sélectionnables dynamiquement : le mode “Non-Thinking” (réponse directe) et le mode “Thinking” (réponse avec raisonnement explicite).

Cette distinction offre une flexibilité inédite pour adapter la profondeur des réponses en fonction du contexte et des besoins de l’utilisateur.

- En mode Non-Thinking, le modèle se comporte comme un assistant conversationnel classique, retournant des réponses courtes, factuelles et synthétiques. C’est idéal pour les requêtes de type Q&R rapides, les demandes nécessitant une réponse immédiate ou les cas où l’on souhaite une réponse concise. Le modèle cache son raisonnement interne et ne donne que la conclusion utile. Par exemple, si l’utilisateur demande « Quelle est la capitale de tel pays ? », DeepSeek répondra directement « La capitale est X. » avec concision.

- En mode Thinking, DeepSeek V3.1 au contraire expose son raisonnement pas à pas. Il va formuler une réponse structurée en déroulant les étapes de réflexion, pouvant inclure des déductions intermédiaires, des calculs, ou des citations de sources d’information. Ce mode est particulièrement utile pour les questions complexes qui requièrent une explication détaillée ou une justification. Par exemple, sur un problème de math ou de code, le modèle détaillera chaque étape de la résolution. Ou bien, face à une question d’analyse d’un document, il pourra citer les passages du texte qui supportent sa réponse. Le <think> mode fournit donc des réponses pédagogiques et transparentes, précieuses pour l’auditabilité du résultat ou pour guider l’utilisateur à travers la solution.

Derrière ces deux modes, le modèle utilise en réalité une même architecture mais avec un formatage de prompt différent.

En pratique, un simple token spécial dans le prompt (ou un paramètre API) permet d’activer ou désactiver le mode réflexion. Par exemple, via l’API Python/HuggingFace, on peut appliquer un chat template avec thinking=True pour insérer les balises nécessaires au mode raisonnement. L’interface officielle de DeepSeek propose quant à elle un bouton « DeepThink » pour basculer en mode réflexion lors d’un chat.

Cette simplicité d’utilisation signifie qu’en tant que développeur, vous pouvez choisir dynamiquement le comportement du modèle en fonction du contexte utilisateur : fournir une réponse brève si c’est ce qui est voulu (par ex. un assistant vocal donnant un fait rapide), ou bien approfondir la réponse si l’utilisateur demande “explique-moi en détail…”.

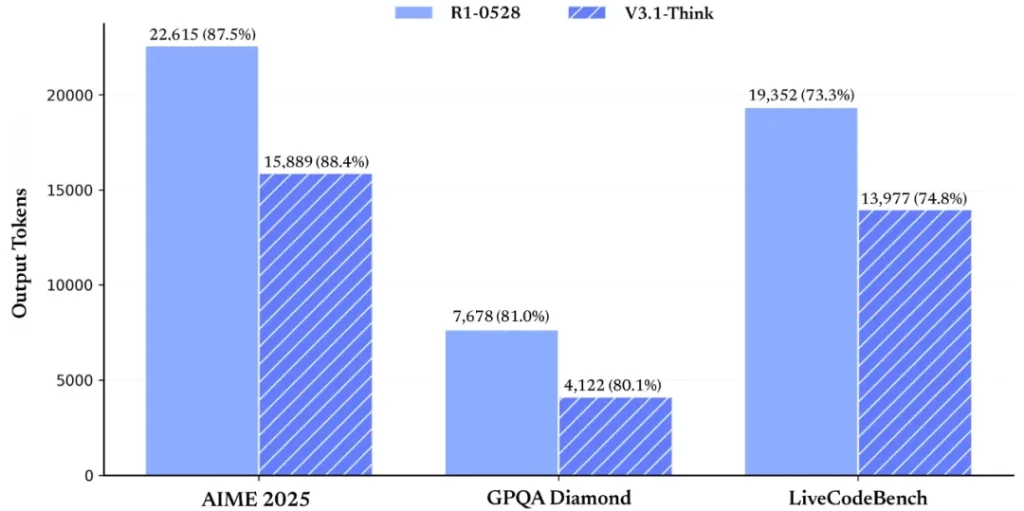

Le mode Thinking ne sert pas seulement à afficher le raisonnement : il améliore aussi objectivement les résultats sur les tâches complexes. Les benchmarks montrent que DeepSeek V3.1 obtient souvent des scores plus élevés en activant le raisonnement pas-à-pas.

Par exemple, sur des questions mathématiques ou de codage, le taux de succès augmente drastiquement en mode thinking (par ex., sur le concours AIME, le taux passe d’environ 50 % en direct à plus de 88 % avec raisonnement explicite). Le modèle parvient mieux à des réponses correctes lorsqu’il peut « penser à voix haute » car il évite les erreurs de raisonnement en vérifiant chaque étape.

Cette efficacité du raisonnement a par ailleurs été optimisée dans la V3.1, le mode thinking étant désormais plus rapide pour arriver à une conclusion qu’il ne l’était dans les versions antérieures.

En somme, les modes Thinking vs Non-Thinking confèrent à DeepSeek V3.1 une souplesse d’utilisation remarquable.

Vous pouvez l’exploiter comme un assistant conversationnel classique rapide, ou comme un agent raisonneur capable de détailler chaque inférence. Peu de modèles offrent cette dualité au sein d’un même système.

Cela s’avère précieux, par exemple, pour des applications éducatives (où l’explication pas-à-pas est souhaitable) vs des applications de support client (où l’on privilégie des réponses courtes et directes). DeepSeek V3.1 vous laisse le choix du niveau de profondeur cognitive à exposer selon vos cas d’usage.

Agents intelligents et utilisation d’outils externes

Au-delà de ses capacités conversationnelles, DeepSeek V3.1 se distingue par son aptitude à s’insérer dans des workflows d’agent IA en collaboration avec des outils externes.

L’équipe DeepSeek présente cette version comme le « premier pas vers l’ère des agents » (“agent era”), car le modèle a explicitement été entraîné et optimisé pour exceller dans des tâches multi-étapes où il doit interagir avec un environnement ou des APIs.

Concrètement, DeepSeek V3.1 peut appeler des outils pendant qu’il traite une requête. Par exemple, s’il ne possède pas en mémoire la réponse à une question factuelle, le modèle peut décider de lancer une recherche web en direct, puis de lire le résultat et d’en extraire la réponse pour l’utilisateur.

De même, face à un problème de code, il peut exécuter du code Python en arrière-plan pour tester quelque chose ou appeler une calculatrice. Cette capacité s’apparente aux approches ReAct (Reasoning and Acting) où le LLM alterne entre étapes de réflexion et actions sur des outils.

DeepSeek V3.1 supporte ainsi nativement un format de tool use dans son prompt (avec des délimiteurs spéciaux pour émettre des appels d’outil), ce qui lui permet de fonctionner en tandem avec un orchestrateur d’outils (navigateur web, interpréteur de code, base de données, etc.).

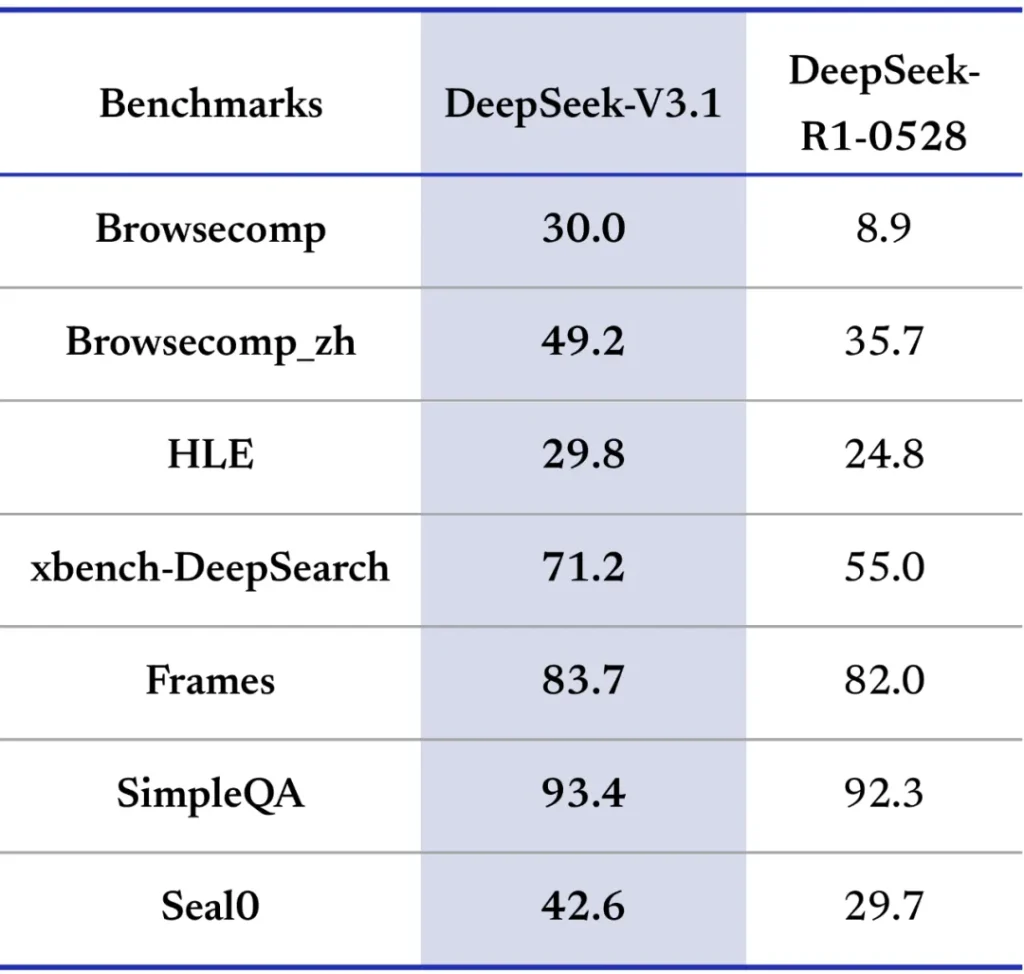

Les bénéfices de cette approche se reflètent dans les performances du modèle sur des benchmarks d’agent.

Par exemple, sur l’évaluation BrowseComp (qui teste la capacité à résoudre des questions en naviguant sur des pages web), DeepSeek V3.1 obtient un score de 30.0 (en mode agent), là où les modèles antérieurs peinaient à atteindre des scores à deux chiffres. Cela indique qu’il sait mieux utiliser un navigateur pour trouver des informations pertinentes.

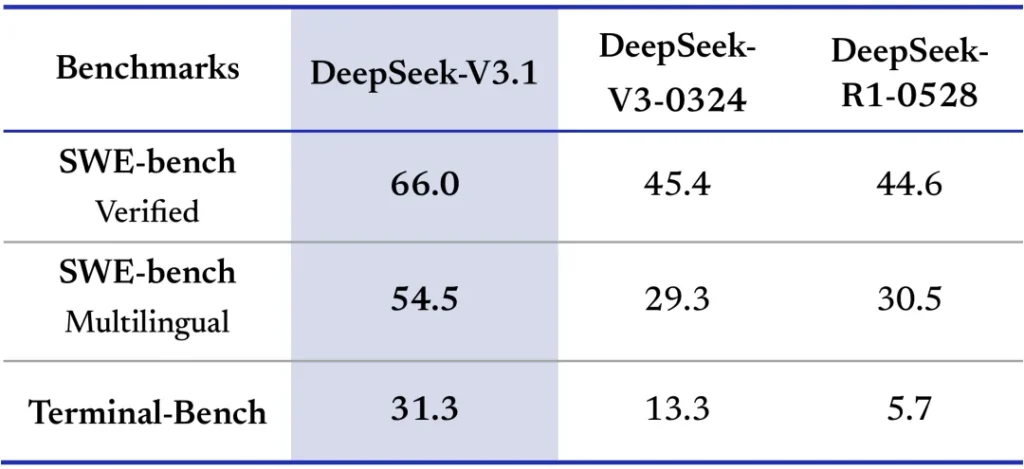

De même, sur Terminal-Bench (benchmark d’agent code en ligne de commande), il atteint 31.3 points, témoignant d’une aptitude solide à exécuter des commandes et à utiliser un terminal virtuel pour accomplir des tâches. Ces résultats sont nettement supérieurs à ceux des anciennes versions ou d’autres modèles open-source, confirmant les compétences d’agent renforcées de la V3.1.

L’équipe annonce d’ailleurs avoir boosté via du post-entraînement spécifique les performances du modèle en usage d’outils et tâches multi-step complexes.

Un aspect intéressant est la présence de tokens spéciaux “cachés” découverts par la communauté, suggérant des hooks internes pour la réflexion et la recherche.

Cela laisse entendre que DeepSeek V3.1 incorpore en profondeur des mécanismes pour gérer son état “réflexion interne” et interfacer avec des modules de recherche, même si toute la documentation n’a pas encore été rendue publique à ce sujet.

Quoi qu’il en soit, en pratique, les développeurs peuvent dès maintenant exploiter DeepSeek V3.1 via des frameworks comme LangChain ou OpenAI function calling pour construire des agents conversationnels capables de consulter des documents, interroger des API, exécuter du code ou effectuer des actions dans un environnement donné, le tout orchestré par l’intelligence du modèle.

Pour illustrer, imaginons que vous souhaitiez réaliser un assistant DevOps qui, en langage naturel, diagnostique un problème serveur puis exécute les commandes nécessaires pour le résoudre : DeepSeek peut comprendre la requête, raisonner sur la cause possible (mode thinking), puis formuler une action (par ex. une commande shell) à exécuter sur le serveur.

L’action est exécutée par le système hôte, le résultat (output) est renvoyé au modèle, qui l’analyse et continue la conversation.

Ce type de boucle perception-action est au cœur des agents autonomes, et DeepSeek V3.1 est spécialement outillé pour cela. En somme, la V3.1 réunit en un seul modèle des fonctions qu’on trouvait auparavant dans des systèmes séparés (chatbot d’un côté, agent spécialisé de l’autre).

Pour les développeurs, c’est la promesse de pouvoir bâtir plus facilement des IA polyvalentes qui non seulement conversent, mais agissent et interagissent avec leur environnement logiciel.

Performances sur les benchmarks de référence

DeepSeek V3.1 a été soumis à une batterie de benchmarks standardisés couvrant un large éventail de tâches (connaissances générales, compréhension de texte, logique, mathématiques, programmation, etc.). Les résultats obtenus confirment qu’il s’agit d’un des modèles open-source les plus performants à ce jour, rivalisant avec des IA beaucoup plus coûteuses ou fermées sur de nombreux indicateurs.

Voici quelques faits saillants des évaluations :

- Connaissances générales (NLP) : Sur le benchmark MMLU (Massive Multi-Task Language Understanding), DeepSeek V3.1 affiche un taux de précision jusqu’à 93,7 % (mode raisonnement). Ce test très complet couvre 57 domaines de connaissance du niveau lycée à supérieur. Un score de ~94 % le place dans le haut du panier des LLM actuels. À titre de comparaison, des modèles réputés comme GPT-3.5 tournent autour de 70‑80 % sur ce benchmark : DeepSeek comble donc largement l’écart et se rapproche des performances de GPT-4, tout en étant open-source. Même en mode non-thinking (réponse directe), il atteint ~91,8 %, montrant qu’il maîtrise d’emblée un large socle de connaissances.

- Raisonnement logique et mathématique : Les capacités de DeepSeek en mathématiques et logique ont été éprouvées sur des épreuves comme AIME (American Invitational Math Exam) ou HMMT. En mode thinking, il réussit ~93 % des questions d’une édition AIME, un résultat quasiment sans précédent pour un modèle open-source sur ce type de problème très complexe. Sur HMMT 2025 (problèmes de mathématiques avancés), il dépasse 84 %. Ces scores indiquent une aptitude poussée au raisonnement symbolique et arithmétique, supportée par le mode chaîne-de-pensée. En outre, sur Humanity’s Last Exam (un ensemble de questions difficiles mélangeant culture générale et réflexion), DeepSeek V3.1 obtient des résultats nettement au-dessus de ses prédécesseurs, démontrant sa robustesse sur les problèmes tordus.

- Programmation et génération de code : DeepSeek V3.1 brille particulièrement sur les benchmarks de codage, traditionnellement dominés par des modèles spécialisés. Sur Aider (benchmark d’assistance à la programmation multi-langages), il atteint environ 76 % de réussite, ce qui le positionne comme l’un des tout meilleurs modèles open-source pour le code. Sur LiveCode (résolution de problèmes de programmation avec évaluation d’exécution), il affiche un pass@1 de ~74,8 % en mode raisonnement, signifiant qu’il trouve la bonne solution du premier coup dans près de 3 cas sur 4 – un niveau équivalent à celui de modèles comme GPT-4 sur des ensembles comparables. De plus, son score au challenge Codeforces Division 1 est d’environ 2091 (cote ELO simulée), ce qui correspond à un niveau Master en concours de code compétitif, une performance rarement atteinte par des IA ouvertes. En agent de code, ses résultats à SWE-bench (tests de réalisation de projets logiciels avec usage d’outil) sont également excellents : ~66 % de réussite sur la version vérifiée, soit plus du double des versions précédentes. Tout cela indique une profonde compréhension de multiples langages de programmation, une capacité à suivre des instructions techniques, et même à déboguer ou améliorer du code existant.

- Multilingue et autres tâches : Bien que la majorité des benchmarks soient en anglais, des tests montrent que DeepSeek V3.1 gère aussi très bien d’autres langues. Par exemple, sur BrowseComp-zh (version chinoise du benchmark de navigation web), il obtient ~49,2, reflétant une aisance à manier le chinois dans un contexte de recherche d’information. De façon générale, le modèle peut être appliqué à des tâches diverses comme l’analyse de sentiments, la classification de texte, la complétion de phrases, etc., avec des scores au niveau de l’état de l’art open-source.

En résumé, l’ensemble de ces performances situe DeepSeek V3.1 comme un modèle de référence parmi les LLM open-source.

Il combinaison d’excellence sur des fronts variés (connaissance, logique, code) là où beaucoup d’autres modèles sont spécialisés dans un domaine au détriment des autres. Cette polyvalence sans compromis en fait une solution de choix pour les développeurs souhaitant un modèle unique pouvant alimenter différents services (Q&A, génération de code, analyse, etc.) tout en maintenant un très haut niveau de qualité.

De plus, le fait de disposer librement des poids et de pouvoir reproduire ces résultats sans dépendance à une API propriétaire constitue un avantage stratégique pour la communauté IA open-source.

Architecture technique et optimisations sous le capot

Pour atteindre de tels niveaux de performance, DeepSeek V3.1 s’appuie sur une architecture novatrice à grande échelle, couplée à des optimisations pointues pour l’entraînement et l’inférence.

Comprendre son fonctionnement interne peut aider les développeurs à mieux cerner ses exigences et son potentiel.

Mixture-of-Experts (MoE) massif : Le cœur du modèle est un réseau de type Transformer géant intégrant la technique du Mixture-of-Experts.

Plutôt que d’avoir une seule suite de couches dense de 37 milliards de paramètres (comme un LLaMA 37B, par exemple), DeepSeek utilise un ensemble d’experts totalisant 671 milliards de paramètres, dont seulement une fraction est activée pour chaque entrée.

En pratique, cela signifie que pour chaque token généré, le modèle route dynamiquement l’information à travers différents experts spécialisés, au lieu de faire passer tout le token par tous les paramètres.

Ce routage intelligent (basé sur l’entrée) permet de bénéficier d’un très grand nombre de paramètres total – ce qui augmente la capacité de modélisation et la diversité des connaissances – tout en gardant le coût d’inférence équivalent à un modèle ~30-40B classique.

DeepSeek V3.1 implémente un MoE efficace avec un équilibrage de charge sans perte (pas d’auxiliary loss de balancing) pour obtenir le meilleur des deux mondes : capacité & rapidité.

Optimisations d’attention et de décodage : Manipuler 128k tokens de contexte de façon fluide nécessite des innovations dans le mécanisme d’attention du Transformer.

DeepSeek V3 (et 3.1) introduit le concept de Multi-Head Latent Attention (MLA). Sans entrer dans tous les détails mathématiques, c’est une variante de l’attention multi-têtes conçue pour réduire le coût mémoire et calculatoire sur de très longues séquences, en factorisant certains calculs et en exploitant des représentations latentes plus compactes.

En parallèle, lors de l’entraînement, un objectif de Multi-Token Prediction (MTP) a été utilisé, ce qui permet au modèle de prédire plusieurs tokens en parallèle et ouvre la porte à des méthodes de décodage spéculatif plus rapides à l’inférence.

En d’autres termes, DeepSeek V3.1 a été entraîné non seulement à prédire le token suivant, mais potentiellement plusieurs tokens d’un coup, ce qui peut accélérer la génération de texte au moment de l’utilisation (en particulier lorsque combiné avec des algorithmes d’inférence avancés).

Ces choix d’ingénierie démontrent la volonté d’allier échelle et efficacité, en rendant l’usage d’un modèle aussi grand viable en pratique grâce à ces optimisations.

Entraînement à l’échelle extrême : Construire DeepSeek V3.1 a nécessité un effort d’entraînement colossal.

D’après le rapport technique, le modèle de base a été pré-entraîné sur 14,8 billions de tokens de données variées de haute qualité – un corpus englobant sans doute plusieurs langues, des textes web, des livres, du code, etc. S’y ajoutent les phases de fine-tuning supervisé (SFT) et d’apprentissage par renforcement avec feedback humain (RLHF) pour affiner ses réponses conversationnelles. L’entraînement distribué s’est déroulé sur des supercalculateurs GPU de dernière génération (clusters de centaines de GPU Nvidia H800/A100). Au total, on estime la dépense de calcul à environ 2,78 millions d’heures GPU H800, ce qui donne une idée de l’ampleur du projet.

Notons qu’une attention particulière a été portée à la stabilité de l’entraînement malgré la taille du modèle : aucune divergence fatale n’a été rencontrée, grâce à des techniques de régulation et une calibration soignée des hyperparamètres pour ce régime d’échelle.

Précision FP8 et déploiement : Une fois le modèle entraîné, l’un des objectifs est de le rendre exploitable en production à moindre coût.

DeepSeek V3.1 innove en étant l’un des premiers LLM open-source à supporter nativement l’inférence en FP8 (format de nombres flottants 8 bits, via un format UE8M0). Cela a été rendu possible en stockant les poids du modèle et les activations directement au format FP8 lors du post-entraînement, et en utilisant des bibliothèques comme DeepGEMM optimisées pour ce format.

Le FP8 divise par 2 le volume mémoire par rapport au FP16, et permet de tirer parti des dernières générations de GPU (Nvidia H100 et suivants) qui prennent en charge le calcul 8-bit avec accélération matérielle.

En pratique, cela signifie qu’un même serveur peut héberger plus de modèles ou traiter plus de requêtes parallèles grâce à la réduction de la taille des données manipulées. Couplé au MoE qui limite le calcul à 37B paramètres par token, DeepSeek V3.1 offre ainsi un débit de génération nettement amélioré par rapport à un modèle dense équivalent.

Les développeurs constatent que même en mode raisonnement complexe, les temps de réponse restent raisonnables compte tenu de la quantité de calcul effectuée – un atout important pour les applications temps-réel ou à fort trafic.

En synthèse, l’architecture de DeepSeek V3.1 démontre qu’il est possible de pousser l’échelle des modèles de langage à des niveaux inédits tout en maintenant leur exploitabilité pratique.

Les choix techniques comme le Mixture-of-Experts, l’attention optimisée, la prédiction multi-token et le support de la faible précision montrent une orientation claire vers le meilleur compromis performance/coût. Pour un développeur, cela signifie que derrière la facilité d’utilisation apparente (une API, un modèle Hugging Face à charger) se cache un énorme travail d’ingénierie qui permet d’obtenir des réponses de très haute qualité sans que les temps d’inférence ou les besoins matériels ne deviennent prohibitifs.

Bien sûr, utiliser tout le potentiel de DeepSeek V3.1 en local reste un défi (37B paramètres actifs requièrent déjà du matériel GPU haut de gamme, idéalement des A100/H100 avec 80 Go de mémoire chacun, ou une distribution sur plusieurs GPU), mais son efficacité relative le rend plus accessible qu’on ne pourrait le penser pour un modèle de cette taille.

Intégration et usages pour les développeurs

Un des points forts de DeepSeek V3.1 est la facilité avec laquelle les développeurs peuvent l’intégrer dans leurs projets et l’adapter à leurs cas d’utilisation.

Voici un tour d’horizon des moyens d’accès et des exemples d’usages possibles de ce modèle par un public technique.

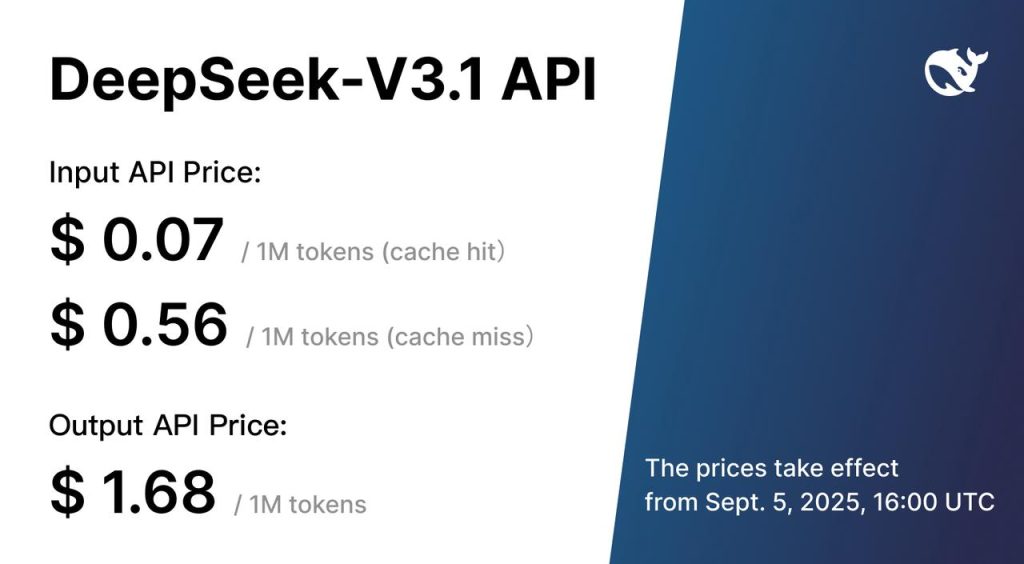

Accès via API et compatibilité OpenAI : Pour commencer, DeepSeek V3.1 est disponible via une API cloud proposée par ses concepteurs (plateforme DeepSeek ou fournisseurs partenaires). Particularité intéressante, ils ont implémenté une interface compatible avec l’API OpenAI.

Autrement dit, si vous avez déjà un code qui interroge l’API de ChatGPT (avec le format POST /v1/chat/completions et un certain format de messages), vous pouvez le rediriger vers l’endpoint de DeepSeek en changeant simplement l’URL et la clé d’API. Le modèle DeepSeek acceptera les mêmes payloads (roles “user”/“assistant”, etc.) et renverra une réponse au format similaire.

Cette compatibilité (ainsi que le support du format d’API Anthropic pour ceux qui en ont besoin) simplifie grandement l’adoption pour quiconque a déjà un code base autour de ChatGPT.

Des services comme OpenRouter offrent justement ce point d’accès unifié : il suffit d’une clé API pour appeler DeepSeek V3.1 sans gérer l’hébergement.

Par exemple, un simple appel HTTP en JSON peut suffire pour obtenir une complétion de DeepSeek, comme illustré ci-dessous :

curl -X POST "https://api.openrouter.ai/v1/chat/completions" \

-H "Authorization: Bearer <API_KEY>" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek/deepseek-chat-v3.1",

"messages": [{"role": "user", "content": "Bonjour, qui es-tu ?"}]

}'

Ce type de requête renverra un JSON avec la réponse générée par DeepSeek V3.1 (en français dans cet exemple).

Le modèle est donc consommable comme un service web standard, ce qui facilite son intégration dans des applications existantes (chatbot web, assistant mobile, backend d’analyse, etc.) sans avoir à maîtriser les détails de son infrastructure.

Auto-hébergement et écosystème open-source : Pour ceux qui souhaitent un contrôle total ou qui disposent de l’infrastructure nécessaire, les poids de DeepSeek V3.1 sont téléchargeables librement (sur Hugging Face notamment).

Il est ainsi possible de déployer le modèle sur vos propres serveurs ou en cloud privé, afin de garantir la maîtrise des données et éventuellement d’adapter le modèle. Comme mentionné, faire tourner la version complète exige du matériel de pointe (idéalement plusieurs GPU connectés en parallèle, avec support de l’FP8 pour tirer parti de l’optimisation).

Cependant, l’écosystème a déjà produit des versions quantisées (en 4-bit, 8-bit) qui réduisent drastiquement la charge mémoire au prix d’une légère perte de précision, rendant envisageable une exécution sur des machines plus modestes. De plus, des outils comme HuggingFace Transformers et Text Generation Inference supportent DeepSeek V3.1, permettant de le charger en quelques lignes de code Python puis de générer des textes de manière optimisée.

L’open-source offre aussi la possibilité d’auditer le modèle, de vérifier son comportement, ou de contribuer à son amélioration (par exemple en publiant des LoRA fine-tunings).

Fine-tuning et spécialisation : Grâce à la licence MIT et à la disponibilité du modèle de base (non conversationnel), les développeurs peuvent fine‑tuner DeepSeek V3.1 sur des données spécifiques à leur domaine.

Par exemple, une entreprise pourrait entraîner une version spécialisée du modèle sur ses documents internes (manuels techniques, base de connaissances) afin d’obtenir un assistant expert connaissant parfaitement ses produits.

Étant donné la taille du modèle, un fine-tuning complet est coûteux, mais des techniques légères comme LoRA (Low-Rank Adaptation) permettent d’entraîner seulement quelques millions de paramètres additionnels pour adapter le modèle, ce qui devient faisable sur du matériel plus courant.

La communauté a d’ailleurs déjà proposé 19 modèles fine-tunés sur HuggingFace (par ex. des versions orientées conversation francophone, ou au contraire des versions allégées pour du déploiement mobile, etc.). Cela signifie qu’il existe potentiellement des points de départ proches de votre usage que vous pouvez réutiliser.

Si vous cherchez à construire un agent conversationnel dans le domaine médical, juridique, financier… il est sans doute possible de spécialiser DeepSeek avec relativement peu de données spécifiques, en capitalisant sur sa base déjà très solide.

Exemples d’applications : Les possibilités offertes par DeepSeek V3.1 se reflètent dans les projets que l’on voit émerger autour.

Voici quelques exemples concrets d’usages qui peuvent inspirer les développeurs :

- Analyse interactive de documents : Comme illustré précédemment, on peut créer une application où l’utilisateur uploade un document PDF volumineux (un article scientifique, un rapport, un contrat juridique) et interagit en langage naturel pour en obtenir un résumé, poser des questions pointues, etc. DeepSeek V3.1 peut ingérer le document entier (grâce au contexte 128k) et répondre de manière précise, avec la possibilité de citer le texte exact du PDF dans ses réponses détaillées. Cela transforme un document statique en assistant intelligent qui “comprend” le contenu et le rend accessible via la conversation.

- Chatbots et assistants virtuels : Que ce soit pour du support client multilingue, un assistant personnel ou un bot de communauté, DeepSeek offre la polyvalence nécessaire. Il peut répondre aux questions fréquentes, résoudre des problèmes techniques en direct (via le mode agent qui permet d’appeler des outils de diagnostic), maintenir une mémoire longue de l’historique client, et fournir des explications claires. Le tout en étant déployable sur site si la confidentialité est un enjeu (grâce à l’open-source). On peut facilement intégrer DeepSeek dans des plateformes de chat existantes (Discord, Slack, applications web) via l’API.

- Aide à la programmation (AI pair programmer) : Avec ses fortes compétences en codage, DeepSeek V3.1 peut servir de base à un assistant de développement style Copilot. On peut l’intégrer dans un IDE ou un outil en ligne de commande pour qu’il suggère du code, explique des erreurs, documente des fonctions, ou automatise des parties de développement. Son mode thinking lui permet de décrire sa démarche, ce qui est utile pour comprendre la solution. De plus, son habilité à exécuter du code (via un agent) pourrait permettre de valider les suggestions avant de les proposer. Des fine-tunings pourraient cibler encore mieux certains langages ou frameworks.

- Systèmes multi-agents : DeepSeek V3.1 peut être le cerveau d’une architecture multi-agents où plusieurs instances collaborent avec différentes spécialités. Par exemple, une instance pourrait gérer la génération de texte narratif pendant qu’une autre s’occupe de vérification factuelle via recherche web, les deux communiquant leurs résultats. Grâce à ses capacités d’outil et à sa longue mémoire, DeepSeek facilite la coordination entre agents (il peut stocker et échanger de grandes quantités d’information contextuelle). Des développeurs explorent déjà des systèmes complexes mêlant plusieurs DeepSeek et d’autres services pour accomplir des tâches longues et ardues de manière autonome.

En définitive, l’intégration de DeepSeek V3.1 est pensée pour être aussi directe que possible pour les développeurs, tout en laissant une liberté totale de personnalisation.

Que vous vouliez l’utiliser tel quel via une API standardisée, ou plonger les mains dans le cambouis pour l’ajuster et l’héberger vous-même, le modèle s’adapte à votre flux de travail. La documentation officielle propose d’ailleurs des guides pour les cas d’usage courants (conversation multi-tour, appels de fonction structurés, etc.).

Avec DeepSeek V3.1, la puissance des grands modèles de langage de pointe est mise à la portée de la communauté, sans barrière à l’entrée, ouvrant la voie à une nouvelle vague d’applications IA toujours plus intelligentes et interactives.

Conclusion : Adoptez DeepSeek V3.1 dans vos projets IA

En conclusion, DeepSeek V3.1 se présente comme un modèle de langage de nouvelle génération riche en innovations techniques et en capacités avancées pour le traitement du langage naturel.

Sa combinaison unique d’une énorme base de connaissances, d’une mémoire contextuelle étendue, de modes de raisonnement adaptatifs et d’une intégration aisée d’outils externes en fait un atout puissant pour tout développeur souhaitant repousser les limites des applications conversationnelles et agentiques actuelles.

Le tout est offert dans un esprit open-source, avec une optimisation qui permet d’envisager des déploiements réels efficaces.

Que vous ayez besoin de générer du texte cohérent en français sur des dizaines de pages, de bâtir un assistant capable d’expliquer pas à pas des concepts complexes, ou de mettre en place un agent autonome qui navigue sur le web et interagit avec votre système, DeepSeek V3.1 fournit l’infrastructure intelligente pour y parvenir.

Sans comparaison directe avec les versions antérieures, cette version se suffit à elle-même : elle apporte aujourd’hui un éventail complet de fonctionnalités prêtes à l’emploi pour faire entrer vos projets dans une nouvelle dimension de l’IA conversationnelle.

Envie d’essayer DeepSeek V3.1 ?

Nous vous invitons à le tester par vous-même et à explorer sa documentation : rendez-vous sur le site officiel deepseek-fr.ai pour une démonstration en français sans inscription, ou consultez la documentation technique et les ressources communautaires sur le dépôt officiel.

Impliquez-vous dans cette révolution open-source – en adoptant DeepSeek V3.1, vous dotez vos applications des capacités linguistiques d’avant-garde qui feront la différence !