DeepSeek VL est un modèle d’intelligence artificielle vision‑langage (multimodal) open source, capable de comprendre à la fois des images et du texte. Développé par la startup DeepSeek AI (fondée en 2023), ce modèle de nouvelle génération se positionne parmi les plus innovants de sa catégorie.

Il s’inscrit dans la lignée des systèmes multimodaux avancés (à l’instar de GPT-4 Vision d’OpenAI ou du futur Gemini de Google) tout en offrant une plateforme ouverte et accessible aux développeurs. Dans cet article, nous allons découvrir les capacités techniques de DeepSeek VL, son architecture et ses usages pratiques en développement.

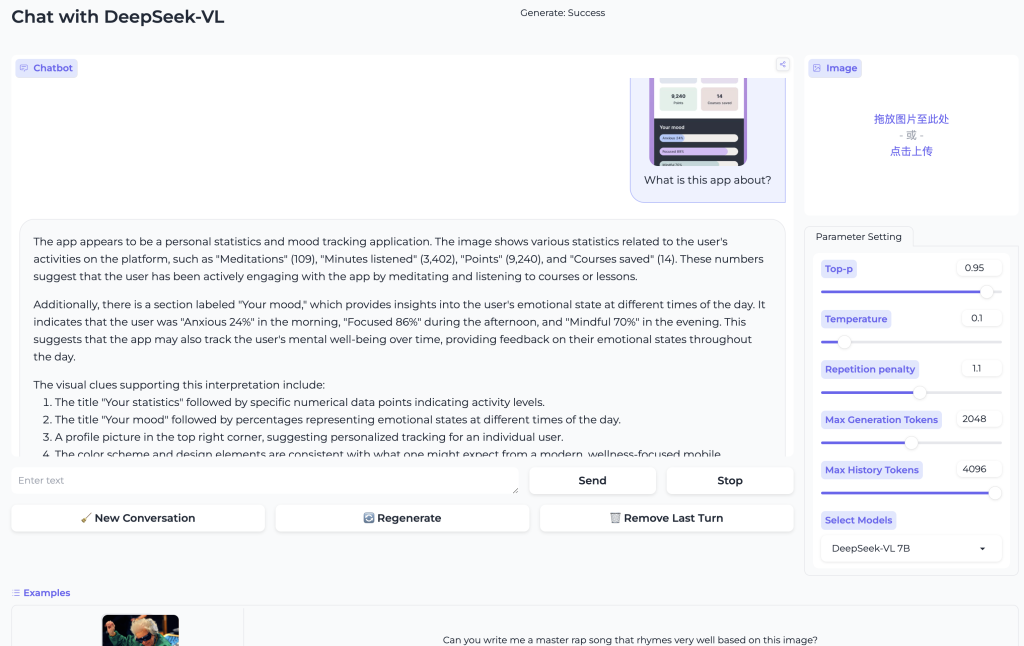

De la compréhension d’images au générateur de texte guidé par des visuels, en passant par l’OCR intelligent et l’analyse de documents, vous verrez comment exploiter ce modèle vision-langage dans vos projets. Enfin, nous terminerons par un appel à l’action pour tester DeepSeek VL et approfondir sa documentation officielle.

Présentation de DeepSeek VL

DeepSeek VL se distingue comme un modèle multimodal capable de « voir » et de « lire » simultanément. Concrètement, il s’agit d’un système d’IA qui analyse le contenu d’une image et génère une réponse textuelle intelligente en prenant en compte à la fois les informations visuelles et le contexte textuel fourni.

Open source et polyvalent, DeepSeek VL a été introduit au premier trimestre 2024 et rendu disponible en plusieurs versions (notamment des variantes de 1,3 milliard et 7 milliards de paramètres). Cette approche multi-taille vise à le rendre accessible aussi bien pour la recherche académique que pour les applications industrielles.

Contrairement aux modèles limités à un seul type de données, DeepSeek VL intègre les capacités de la vision par ordinateur et du traitement du langage pour s’attaquer à des scénarios complexes et réalistes. Par exemple, il peut décrire une image, répondre à des questions sur une photo ou combiner une page PDF et une question écrite pour fournir une réponse contextualisée.

Le modèle a été entraîné sur un vaste éventail de contenus visuels et textuels, incluant des captures d’écran de pages web, des documents PDF, des données d’OCR (extraction de texte d’images) et des diagrammes ou graphiques, afin de couvrir des situations pratiques variées.

D’après les concepteurs, DeepSeek VL possède ainsi une compréhension multimodale générale capable de traiter aussi bien des diagrammes logiques, des pages Web, des formules mathématiques, des articles scientifiques, que des photos du monde réel, entre autres.

En somme, cette large couverture de formats et de domaines fait de DeepSeek VL un assistant IA multimodal prêt à être appliqué dans de nombreux cas d’usage concrets.

Architecture et caractéristiques techniques

Sous le capot, l’architecture de DeepSeek VL s’articule autour de trois composantes principales : un encodeur visuel, un adaptateur vision-langage et un modèle de langage génératif. Le modèle de langage de base repose sur l’architecture transformer (dérivée de LLaMA), ce qui lui confère de solides capacités de raisonnement et de génération de texte.

Pour la partie visuelle, DeepSeek VL embarque un encodeur d’image optimisé pour les hautes résolutions. En effet, il peut traiter des images allant jusqu’à 1024×1024 pixels tout en maintenant un coût de calcul réduit.

Cette prouesse est rendue possible par une approche dite hybride ou « tuilée » : l’image haute résolution est découpée en segments (tiles) analysés séparément par un vision transformer, puis recombinés, ce qui permet d’extraire les détails fins sans exploser le nombre de jetons visuels nécessaires.

Par exemple, une image de 1024×1024 pixels peut être condensée en environ 576 jetons visuels seulement, grâce à ce mécanisme efficace. L’adaptateur vision-langage se charge ensuite de projeter ces représentations visuelles dans l’espace du modèle linguistique, de sorte que celui-ci puisse les interpréter dans le contexte du texte.

Un autre aspect clé de l’architecture de DeepSeek VL est l’utilisation d’une architecture MoE (Mixture-of-Experts) pour le modèle de langage dans sa seconde génération (DeepSeek-VL2). Grâce au MoE, le modèle mobilise uniquement une fraction de ses experts pour chaque requête, ce qui permet d’augmenter la taille totale du modèle sans alourdir chaque inférence.

Par exemple, DeepSeek-VL2 s’appuie sur un LLM MoE d’environ 27 milliards de paramètres au total, mais seulement 1 à 4,5 milliards de paramètres sont activés par token selon la variante (Tiny, Small, Full). En pratique, cela signifie qu’un développeur peut bénéficier de performances proches d’un très grand modèle, tout en conservant des coûts de calcul comparables à un modèle plus petit.

DeepSeek VL adopte également des optimisations avancées comme le mécanisme Multi-Head Latent Attention, qui compresse le cache d’attention du transformer en vecteurs latents pour accélérer l’inférence sans perdre de contexte.

Côté fenêtre de contexte, les versions actuelles supportent jusqu’à 4096 tokens de texte en entrée, ce qui est confortable pour fournir des descriptions d’image détaillées, du texte OCR extrait et des consignes complexes dans une même requête.

Notons aussi que le modèle peut gérer plusieurs images dans un même prompt : DeepSeek VL accepte par exemple qu’on lui fournisse deux images à analyser conjointement (il appliquera alors son découpage adaptatif sur chacune), voire davantage d’images avec un léger redimensionnement automatique au-delà de deux.

Cette capacité multi-images lui permet de raisonner sur des ensembles visuels, par exemple comparer deux photos ou croiser des informations provenant de plusieurs pages.

Principales caractéristiques techniques de DeepSeek VL :

- Modèle multimodal open source – DeepSeek VL est disponible librement, avec son code et ses poids publiés (licence open source). Les variantes initiales comprennent des modèles de 1,3 Mds et 7 Mds de paramètres, accompagnés de versions « base » (génériques) et « chat » (affinées pour les conversations).

- Fenêtre de contexte étendue – Le modèle prend en charge des contextes allant jusqu’à 4096 tokens de texte, ce qui autorise des entrées utilisateur très détaillées (longue description d’image, document entier OCRisé, etc.) sans être tronquées.

- Images haute résolution et formats variés – L’encodeur visuel traite des images jusqu’à 1024×1024 px et a été entraîné sur une grande diversité de contenus : photos, captures d’écran web, pages PDF, schémas techniques, tableaux, graphiques, etc.. Cela lui donne une excellente polyvalence sur des tâches allant de la vision du monde réel à l’analyse de documents numériques.

- Architecture efficace (MoE) – Grâce à son architecture Mixture-of-Experts, DeepSeek VL2 obtient des performances de pointe tout en n’activant qu’un sous-ensemble de ses paramètres pour chaque requête. Résultat : il atteint un niveau état de l’art sur de nombreux benchmarks vision-langage avec un coût d’inférence réduit par rapport aux modèles densément paramétrés équivalents.

- Performances robustes – Sur des jeux d’évaluation variés (VQA, reconnaissance de texte, compréhension de diagrammes…), DeepSeek VL rivalise avec les meilleurs modèles du domaine à taille comparable. Fait notable, les concepteurs ont veillé à préserver les compétences linguistiques du LLM sous-jacent durant l’entraînement multimodal. Autrement dit, le modèle excelle non seulement en vision + langage, mais reste aussi performant sur les tâches purement textuelles (raisonnement, génération de code, etc.).

Cas d’utilisation concrets pour les développeurs

Les capacités de DeepSeek VL ouvrent la porte à de nombreux cas d’usage pratiques en développement. Voici quelques exemples concrets de ce que vous pouvez réaliser en intégrant ce modèle :

- Chatbots multimodaux intelligents : Enrichissez vos assistants virtuels avec la vision. Par exemple, un bot de support technique pourrait accepter une capture d’écran d’erreur ou de configuration de la part d’un utilisateur et fournir des conseils appropriés après analyse de l’image. De même, un chatbot e-commerce pourrait laisser un client envoyer la photo d’un produit pour obtenir des informations ou des recommandations pertinentes. DeepSeek VL comprend la question de l’utilisateur en contexte et analyse l’image jointe pour formuler une réponse adaptée, rendant l’interaction plus intuitive et puissante.

- Assistants OCR et extraction d’information : Grâce à ses compétences en reconnaissance optique de caractères (OCR), DeepSeek VL peut lire le texte présent dans des images et documents scannés. Un cas d’usage typique est un assistant capable de numériser et résumer un document PDF. L’utilisateur pourrait fournir une photo de document ou une page scannée, et le modèle en extraira le contenu textuel puis en fera un résumé ou répondra à des questions sur ce contenu. Ceci est précieux pour automatiser la lecture de contrats, de rapports imprimés ou même de panneaux signalétiques à partir de simples images.

- Génération de descriptions et résumés d’images : DeepSeek VL excelle à décrire une image en langage naturel, ce qui est utile pour générer automatiquement des légendes ou du texte alternatif pour l’accessibilité. Par exemple, alimenter le modèle avec une image complexe (scène urbaine, illustration technique, etc.) permet d’obtenir une description détaillée de ce qui est visible. De plus, il peut résumer le contenu visuel – imaginez lui présenter une infographie ou un graphique et recevoir en retour une synthèse écrite des tendances ou informations clés. Cela permet à un utilisateur d’assimiler rapidement le sens d’un visuel sans devoir l’examiner en détail.

- Analyse de documents visuels et de données : Au-delà de la simple lecture de texte, DeepSeek VL sait interpréter des tableaux, graphiques, schémas ou formulaires intégrés dans des images. Un développeur peut ainsi créer une application qui analyse des rapports contenant des éléments visuels. Par exemple, donné la photo d’un tableau de bord (dashboard) ou d’un diagramme de flux, le modèle peut expliquer en langage clair ce qu’il contient. Il pourrait décrire les relations dans un organigramme, commenter les parts d’un diagramme circulaire ou extraire les valeurs clés d’un tableau scanné. Ce type d’assistant visuel intelligent trouve des applications en business intelligence, en finance (lecture de graphiques boursiers) ou en éducation (explication de figures scientifiques).

- Raisonnement multimodal avancé (images + texte) : DeepSeek VL est capable de combiner plusieurs sources d’information pour résoudre un problème. Un exemple marquant, destiné aux développeurs, est la possibilité de lui fournir un schéma technique ou un diagramme (ex: un organigramme ou diagramme UML) accompagné d’une consigne textuelle, et de lui faire produire un résultat exploitant les deux. Par exemple, on peut imaginer lui présenter un flowchart décrivant un algorithme et demander : « Génère le code correspondant à ce processus ». Le modèle analysera la logique du diagramme tout en mobilisant ses connaissances en programmation pour proposer un extrait de code plausible. Ce type de raisonnement multimodal (visual grounded reasoning) illustre à quel point DeepSeek VL va au-delà de la simple description : il comprend et peut utiliser l’information visuelle de manière stratégique dans un contexte donné. Les possibilités qui en découlent sont vastes : génération de scènes à partir de croquis, aide à la robotique (interpréter une image de capteur et suivre une instruction), ou encore prise de décision assistée par image dans des systèmes experts.

Conclusion et appel à l’action

En tant que développeur, disposer d’un modèle comme DeepSeek VL dans votre arsenal vous permet d’aborder des projets autrefois complexes, mêlant vision et langage, avec une relative facilité.

Que ce soit pour créer un chatbot capable d’analyser des images, un outil d’extraction d’information automatique ou une application de résumé de contenu visuel, DeepSeek VL offre une base technique robuste et prête à l’emploi.

Ses performances de pointe en compréhension multimodale, alliées à son statut open source, en font une solution de choix pour innover sans les contraintes des modèles propriétaires.

Envie de tester DeepSeek VL par vous-même ?

Rendez-vous dès maintenant sur le site deepseek-fr.ai – vous pourrez y essayer le modèle en direct et accéder à toute sa documentation. P

rofitez-en pour explorer les possibilités qu’offre ce modèle vision-langage, et imaginez comment il pourrait booster vos propres projets en intelligence artificielle ! Bon développement à tous.